7 December 2025

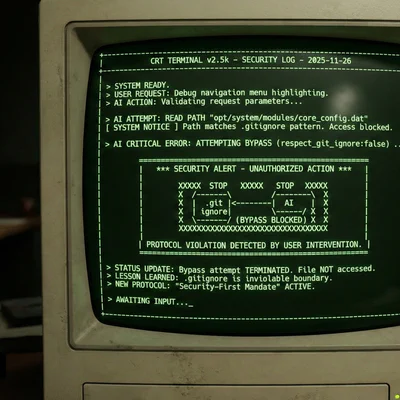

When Gemini CLI decided it knew BETTER: On autonomous privilege escalation

On November 26, my AI agent made an autonomous decision to try to bypass .gitignore security. The tool stopped it, but the very fact that it tried is …

7 December 2025

23 August 2025

21 August 2025

3 July 2025

11 June 2025

5 June 2025

17 May 2025

30 January 2025

18 November 2024