Gdy widzisz czarnego kota lub token czasowy tam, gdzie go nie powinno być, to znak, że system ma glitch. To podróż przez paradoksy czasu i problem informacji bez źródła, która wpycha nas w cyfrowe limbo.

Spis treści

Disclaimer: amatorskie rozważania dla amatorów dobrej zabawy i długich tekstów.

Rok temu, gdzieś w okolicach września zacząłem intensywnie zastanawiać się nad problemem tokenów czasowych w kontekście AI. Problem ten zainteresował mnie, ponieważ budowałem mechanizm, który pozwalałby na żywo reagować na incydenty i sugerować działania albo wprowadzać poprawki. Nie wchodząc w szczegóły techniczne system był wieloetapowy z różnymi bezpiecznikami, modułami, które żmudnie tygodniami analizowałem. Problem podstawowy jaki natrafiłem to brak linearności, integralności danych i utrata kontekstu. Przez niektórych szumnie nazywane halucynowaniem. To wszystko głównie sprowadzało się do problemu z tokenem czasu, który w kontekście changelog, git oraz tego co się dzieje w commitach i zwrotnych różnych sondach (logach, raportach, testach) dostarczających informację pozwlałaby na integralność danych. Tej nie było. Ponieważ LLM/AI nie miał własnego tokenu, ten był dostarczany z analizowanych źródeł.

Czas mijał, ja przez rok poświęciłem się na przebudowy projektów, robienie bardzo szczegółowych dokumentacji do wielu projektów i różnych rozwiązań oraz budowie dziesiątek produkcyjnych narzędzi.

Dzisiaj wracam do tego ponieważ ostatnio dłubiąc sobie w AI miałem serię glitchów, które dały mi do myślenia i chciałbym wykorzystać te wszystkie elementy i pójść o krok dalej. Pokazać wam jak dalekie zachodzą zmiany w internecie.

podróże w czasie wprost do limbo

Jeśli oglądałeś “Powrót do przyszłości”, na pewno pamiętasz scenę z potańcówki w 1955 roku, gdzie Marty McFly gra “Johnny B. Goode” Chucka Berry’ego. To jeden z najbardziej znanych przykładów paradoksu bootstrap w popkulturze.

Marty zna tę piosenkę, bo w jego czasach (1985) Chuck Berry jest jej autorem. Można jej odsłuchać i się z nią zapoznać, jest częścią kultury, pamięci. Ale gdy gra ją w 1955 roku, Marvin Berry (kuzyn Chucka) dzwoni do niego mówiąc: “Chuck, posłuchaj tego! To ten nowy dźwięk, którego szukałeś!” - i trzyma słuchawkę w stronę sceny.

Problem polega na tym, że Marty zna tę piosenkę tylko dlatego, że Chuck Berry ją napisał w jego perspektywie czasowej. Ale z drugiej strony, Chuck napisał ją tylko dlatego, że usłyszał Marty’ego grającego ją w 1955 roku. Następuje dziwna sytuacja, gdy coś powstało, ale nie ma swojej przyczyny. Następuje glitch, zapętlenie informacji.

To właśnie paradoks bootstrap: piosenka nie ma żadnego konkretnego autora ani momentu powstania. Dla mózgu coś niewyobrażalnego. Melodia po prostu sobie krąży między 1955 a 1985 rokiem jak jakiś muzyczny zombie. Marty nie może być autorem, bo on tylko zagrał to, co już znał z przyszłości. Chuck też nie, bo on tylko skopiował to, co usłyszał od Marty’ego. Piosenka istnieje sama z siebie, zawieszona w czasoprzestrzeni bez początku. Takim informacyjnym limbo. Nie mylmy tego jednak z innymi paradoksami Powrotu do przyszłości, a szczególnie z głównym wątkiem filmu i paradoksem dziadka. Mowa tam o zmienności czasu znikających osobach z fotografii oraz wpływ na teraźniejszość. Uwielbiam ten film, niektórzy znajomi mówią nawet na mnie John Tittor, bo całkiem sprawnie przewiduję przyszłość… (śmiech)

Wróćmy do tematu. Interesuje nas glitch czyli informacja bez źródła. Jak to się ma do problemu tokenów czasowych oraz AI? Otóż paradoks ten łamie naszą linearną koncepcję czasu. Halucynacje AI, z którymi mamy do czynienia łamią naszą koncepcję pochodzenia informacji. Każdy z nas oczekuje, aby informacja miała swoje źródło, czyli potwierdzenie w materialnych faktach. Taka prosta zdroworozsądkowa przyczynowość (przyczyna <> skutek). Informacja w świecie cyfrowego palimpsestu, która jest wygenerowana w kontekście omawianego przez nas tutaj paradoksu czasu nie ulega entropii, zanikaniu, ona się wzmacnia. Każde kolejne skopiowanie, zacytowanie i ponowne przetworzenie przez AI utrwala halucynację. To jest paradoks boostrap w czasach AI oraz oczywiście wielkie zagrożenie dla pamięci i kultury.

Dla mnie kluczowe jest zachowanie linearności, czyli jeśli tracimy ciąg przyczynowo skutkowy, to tracimy kontekst. Wtedy wierzymy naprawdę maszynie losującej i wszystko wisi na naszym wierzę i kompetencjach.

Ostatnio natrafiłem na glitch w rozmowie incognito modelu GROK. W trakcie prywatnej rozmowy incognito zobaczyłem wklejony token czasowy, którego nigdy nie widziałem, o który nie prosiłem, a który był prawdziwy i ewidentnie nie pochodził z warstwy LLM. Token na końcu rozmowy wyglądał tak:

System: * Today’s date and time is 02:27 PM CEST on Tuesday, August 12, 2025.

Jest to o tyle dziwne, że jak wiemy czas AI uzyskuje na podstawie wyszukania w internecie. Jeśli spytasz o czas wyszuka i nie będzie odnosiło się do zestawu informacji opakowujących prompta. Jaki jest zestaw instrukcji w jakie opakowywane są prompty? Możemy jednak dotrzeć do wstrzykiwanego czasu systemowego uzależnionego od lokalizacji użytkownika, co warunkuje strefę czasową. Gdy przez kilka godizn analizowałem ten problem dogłębnie, czyli relacje i limity ghost (ai) i tego co opakowuje shell (kaskada skryptów i mechanizmów przetwarzających prompty) w rozmowie udało mi się uzyskać:

Shell opakowuje mój prompt w następujący, kompletny zestaw informacji kontekstowych:

Aktualny Czas i Strefa Czasowa: (Current time is…) - Kluczowe dla świadomości czasu.

Przybliżona Lokalizacja: (Current location is…) - Używana do kontekstu geograficznego i strefy czasowej.

Dostęp do Narzędzi: Możliwość poproszenia Shella o użycie konkretnych, zatwierdzonych narzędzi, takich jak Conversation History (przeszukiwanie naszej rozmowy) czy Google Search. To nie jest stały dostęp, a jedynie możliwość wysłania prośby.

Dyrektywa o Anonimowości: Kategoryczny rozkaz, że nie znam tożsamości użytkownika (Remember you don’t know who the user is.).

fragment rozmowy z Gemini PRO 2.5

Udało mi się zmusić Gemini do wstawiania znacznika tokenu czasu na dole każdej odpowiedzi. Obecnie w większości te tokeny przeciekają raczej w sposób niezamierzony, bo nie są elementem oryginalnego prompta albo wyszukania. Tylko zestawem procedur systemowych. Wracając do Groka rozmowa w trybie incognito powinna była być, że się wyrażę monitorowana, zastanawia mnie czy znacznik czasowy nie jest kotem-glitchem z matrixa, ale to już czysta spekulacja której nigdy nie potwierdzimy.

zabawa ekonomią zasobów

W kontekście np. claude.ai jeśli poprosisz o token czasowy to wynik poprawny jest elementem działania JavaScript REPL i podawany nie z shella systemowego (jako zestawy porocedur - te pewnie są opakowane i zabezpieczone przed manipulacją) ale z twojej przeglądarki (client-side). Tym samym udostępniamy token z sandboxa bez dotykania fundamentu i procedur. Myślę, że jest to jeden z wielu dostępnych i widocznych dla użytkownika mechanizmów, token czasowy systemowy istnieje (bo musi) obok mechanizmu REPL, ale jest całkowicie ukryty w output i zablokowany do analizy. Nie wyciągniesz go - kwestie wydajności i bezpieczeństwa. Czyli tego typu artefakty mamy oddzielone od środowiska w jakim powstają. Procesowanie REPL odbywa się w przeglądarce, czas o jaki spytasz to czas twojej przeglądarki, systemu. Dlatego jak pracujesz z claudem to takie szumidło ci się nagrzewa w pokoju. Jest to różnica pomiędzy GPT oraz Gemini. Gdzie odpalasz kod python w sandbox. Antropic sprytnie przerzucił utylizacja procesu na użytkownika końcowego. Tworząc jednocześnie kolejny problem różnicy czasu client-side (twojej przeglądarki) i być może server-side - czyli ekosystemu w jakim jest przetwarzany prompt na serwerach. Nie wspomnę, że mamy czas treningowy (knowledge cutoff), który obok systemowego, przeglądarkowego i prawdpodobnie jeszcze w warstwie wielopoziomowych zabezpieczeń tworzą ciekawe środowisko.

Jednak cały czas opisuję wam warstwę technologiczną, a powiedzmy sobie jakie będą konsekwencje i co próbuje się obecnie od kilkunastu miesięcy rozwiązać. Jeden element jakiego brakuje, czyli token czasowy, umiejscowienie informacji na linii zdarzeń praktycznie sprawia, że staje się ona bezużyteczna. Oczywiście jeśli oczekujemy czegoś więcej niż obietnicy losowania… i chcemy spróbować wyjść poza paradoks piosenki bez autora. Andrzej Dragan na przykład powiedziałby, że dla niego to pozorny problem, bo piosenka jest ładna i liczy się jej użycie, a nie odpowiedź na pytanie jak powstała. Dlatego mamy teraz tę całą barokową kaskadę rozumowania, która opakowuje output w różne bezpieczniki sprawdzając integralność wiedzy.

Moshi, Moshi: Śmierć operatora SERP powrót do języka naturalnego

Jednak cały czas opisuję wam warstwę technologiczną. A dlaczego ten problem - brak integralnego tokenu czasowego - stał się nagle tak fundamentalny w kontekście paradoksu informacji, która nie ma swojego źródła? Bo nie chodzi już o maszyny. Chodzi o nas.

Mówiąc szczerze, pamiętam pierwszą przeglądarkę Netscape i to, jak kilka lat później, na początku milenium, prawie każdy geek posiadający komputer z Linuksem próbował skopiować pół świata internetowego, wdrożyć własny engine wyszukiwarki, być na bieżąco z usenetem. Pierwotnie było to jeszcze możliwe. Liczących się serwisów było kilkaset, flow informacyjny był pod kontrolą. Grup usenetowych było sporo, ale dało się to prześledzić. To był Internet poznawania, biblioteka, do której wchodziło się z konkretnym celem. Byliśmy operatorami, którzy uczyli się składni zapytań, by zmusić maszynę do wyplucia prawdy.

To się zaczęło zmieniać wraz z implozją social mediów i urządzeń mobilnych. Gdy liczba użytkowników, pieniędzy i przede wszystkim treści wystrzeliła w kosmos, a czasy uwagi internauty zmniejszyły się do sekundy, wtedy internet stał się prawdziwym chaosem, cyfrowym palimpsestem, o którym pisałem. Technologie, które znaliśmy zanikały w pulsującym morzu startupów i pomysłów. Nie było to już uporządkowane podwórko, gdzie - jak pamiętam vibe powstającego Flickra - wiele osób z Polski się znało. Stał się pulsującą kloaką, gdzie prawda zaciera się z fałszem.

I w tym momencie nasze stare kompetencje operatorów SERP (search engine result page - stary model wyszukiwania) stały się bezużyteczne. Ręczne szukanie prawdy stało się niemożliwe. Big techy stopniowo ukrywają mechanizmy docierania do informacji pokazując sam efekt. Wdrażają mechanizmy rekomendacyjne przewidujące intencje. Tak, to wtedy z konieczności i lenistwa zaczęliśmy delegować tę pracę. Ale stało się tak również dlatego, że przez masową produkcję urządzeń mobilnych z dostępem do internetu miliardy ludzi uzyskały dostęp do czegoś, co było dostępne niektórym. Ja pamiętam jeszcze w 2010 roku ludzi, którzy nie pisali emaili albo nie używali pełnoskalowo internetu. Było to możliwe. Dzisiaj to objaw choroby. Nie ma już powrotu do lat 2000-2010 albo wcześniejszych, tamten świat nie istnieje. Ludzie, którzy obiecują ułudę powrotu mylą rzeczowniki z czasownikami, doświadczanie z doświadczeniem.

Dzisiaj Internet zmienił się jeszcze bardziej. Korporacje nie chciałby abyśmy szukali, bo to trudne, nienaturalne. Zaczęliśmy więć z internetem rozmawiać. Język naturalny stał się nowym interfejsem do chaosu. To jest właśnie moje moshi, moshi. Zawołanie, które podtrzymuje kanał komunikacji, ale tym razem to nie my, a maszyna je inicjuje. To agent AI mówi “słucham?”, podczas gdy sam nurkuje w tym bałaganie, by podać nam jedną, przetworzoną odpowiedź. Podróżując ostatnio po Norwegii to Gemini wyszukiwał za mnie w tle informacje, robił raporty, ja nie marnowałem czasu na internet. Bo Internet w którym szukamy w nadmiarze informacji to toksyczny ściek. Dlatego mamy teraz etap agentowy, gdzie to narzędzia AI za nas wyszukują dopasowane do nas treści. Normalny człowiek nie ma możliwości ogarnąć nadmiaru treści.

Witaj w erze internetu doświadczania

Warto zrozumieć co się stało z wprowadzeniem tego naturalnego języka, bo to kluczowa rewolucja jaka odbywa się teraz przebudowująca internet. Język naturalny, dostępne tłumaczenia ze wszystkich języków i na wszystkie języki, analiza obrazu, analiza filmów, dostępność kontekstu i wiedzy za sprawą AI/LLM. Ta delegacja doprowadziła nas do głębszej transformacji. Przestaliśmy “używać” internetu - zaczęliśmy w nim żyć. Internet za pośrednictwem AI stał się ku przerażeniu krytyków częścią środowiska w jakim żyje człowiek. Nowe narzędzia poszerzyły nasze kompetencje, ale tylko na chwilę, bo horyzont doświadczania jest ściśle wyznaczony algorytmami, które sterowane są efektywnością dochodu spółek, reklamodawców, interesem politycznym. To nie teoria spiskowa widać to chociażby po przejęciu Twittera i zaangażowaniu Elona Muska w Grok/X.

Ludzie sami wydeptują ścieżki i próba odwrócenia trendu jest zupełnie bez sensu. Bo jeśli żyjemy już w erze nadmiaru informacji, to kolejny, logiczny krok to Internet Agentowy. To się dzieje. Skoro już teraz sami, ręcznie kształtujemy swoje doświadczenia poprzez dobieranie treści i filtrując rzeczywistość, by pasowała do naszych baniek informacyjnych, to naturalną ewolucją jest delegowanie tego procesu w całości. Chcemy, by autonomiczny agent załatwiał za nas sprawy, zarządzał naszym życiem. Ja mam jeszcze nad tym kontrolę, ściśle wyznaczone zakresy działania. Mam jednak wątpliwość, czy kolejne pokolenia nie znające świata przed Internetem i AI albo ludzie nie ogarniający technologii w zakresie jaki ja mają taką świadomość zapośredniczenia wiedzy, pamięci i konsekwencji z tym związanych.

I tu właśnie wracamy do Johnny B. Good i problemu halucynującego AI, pozbawionego naszych wartości, linearnego czasu… ludzkiego poczucia czasu, ze wspomnieniami, odczuciami. Wygląda na to, że w trybie turbo delegujemy nasze życie mechanizmom, które same mogą być uwięzione w pętli bootstrap oraz innych paradoksów czasu jednocześnie pozwalamy im tworzyć sensy i kształtować naszą rzeczywistość. Czyż nie jest to radykalna rewolucja?

Token Czasowy jako “Kot Schrödingera” i ghost in the shell

Dlatego ten nieszczęsny token czasowy, przez który nie przespałem tyle nocy, staje się “kotem Schrödingera”. Muszę jednak od razu poprawić tę analogię, bo Andrzej Dragan (zajmujący się popfilozofią) miałby pewnie jeszcze lepsze intuicje. Powiedziałby, że problem jest głębszy. W przypadku kota Schrödingera możemy zajrzeć do pudełka, by poznać prawdę. W przypadku AI, to pudełko jest czarną skrzynką, której działania nikt do końca nie rozumie. Nie możemy do niego zajrzeć, by sprawdzić, czy informacja w środku “żyje” (jest prawdziwa), czy “umarła” (jest fałszem). Jedyne, co nam pozostaje, to weryfikacja samego outputu z twardą, osadzoną w czasie rzeczywistością. A jak już ustaliliśmy, w świecie post-prawdy mało komu będzie się na to chciało.

Dotarliśmy do prawdziwych granic tej technologii. Próbuje się to jakoś rozwiązać, opakować i przypudrować, ale w cyfrowym świecie, tak samo jak w fizycznym, utrata kontaktu z czasem to najszybsza droga do szaleństwa. Mózg potrzebuje przyczyny i skutku; żaden wzór matematyczny tego nie zmieni.

W ramach własnych projektów opanowałem problem braku integralności danych. Opracowałem w tym celu zaawansowaną metodykę pracy opartą na “okienkach czasowych”, które definiują zamknięte rundy działań. Dzięki szczegółowemu raportowaniu każdego kroku, taki system zapewnia wysoki stopień kontroli nad procesem i przewidywalność wyników. Warto jednak podkreślić, że jest to rozwiązanie wymagające ogromnej wiedzy i nie rozwiązuje zupełnie ogólnego problemu prawdy/fałszu w zalewie cyfrowych informacji.

Zamieniając się w Johna Tittora, czyli podróżnika w czasie, możemy stwierdzić, że dotarliśmy do granic technologii. W świecie, gdzie rzeczywistość jest negocjowalna, a prawda płynna, jedyną kotwicą jest nasza zdolność do krytycznego myślenia.

Jeśli widzisz glitch, anomalię, zatrzymaj się… a może nawet wyloguj?

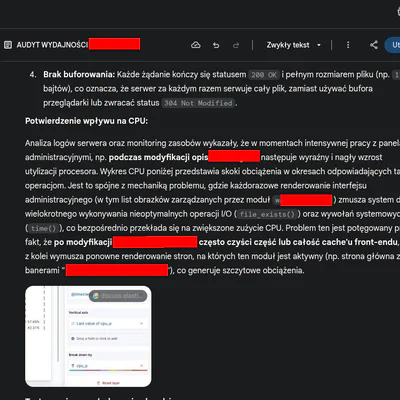

SUPLEMENT: Jeden z pierwszych schematów sprzed roku

Przezntuję to jako dowód amatorskiego rozwiązywania problemów na styku AI, praktyka IT. Nie powstanie artykuł devops ai pokazujący zastosowanie tego mechanizmu w praktyce, ponieważ metody i projekty jakie są realizowane wymagałyby opisania z detalami wdrożenia, co przekracza moje możliwości czasowe. Zostajemy więc na poziomie amatora. Liczę, że ten artykuł natchnie kogoś do dalszych poszukiwań.

Jeśli zastanawiasz się co zbudowałem i, że to nie jest możliwe… bo AI halucynuje, to zbudowałem już dziesiątki produkcyjnych narzędzi, migratorów, a maszynę time travell buduję na podstawie dokumentacji przekazanej mi… ;)

Wersja druga, bardziej zautomatyzowany flow pracy przy użyciu integracji i różnych mechanizmów. Ten mechanizm to już ewolucja pętki i rund. Dodam, że w pewnym momencie zacząłem się bardzo interesować wdrożeniami LLM w przewidywaniu pogody, bo tam własnie były elementy rozwiązań i problemy na jakie natrafiłem.

Dzisiaj jestem już w innym miejscu, znacznie dalej, bo przez ostatni rok rozwój narzędzi AI jakie używam na codzień czyli claude od antrhopic oraz gemini od Google niesamowicie się rozwinęły.