Boty OpenAI masowo skanują strony internetowe. Co to oznacza dla przyszłości wyszukiwania, SEO i sposobu konsumpcji treści w sieci? Analiza zjawiska i prognozy na najbliższe 5 lat.

Spis treści

Ostatnio Jakub ‘unknow’ Mrugalski podzielił się ciekawą obserwacją na swoim profilu Mastodon:

Zauważyłem wzmożony ruch od OpenAI na swoim serwerze z projektami. Wczoraj ponad 787 tysięcy odwiedzin bota od ChatGPT, a dziś już ponad 377k. Ciekawostki: pobiera nie tylko HTML, ale i niektóre grafiki + pliki JS, respektuje robots.txt, pobiera pliki ZIP. Wcześniej było tego znacznie (~100x) mniej. Czyżby OpenAI na poważnie wzięło się za indeksowanie netu w celu zagrożenia Google? źródło

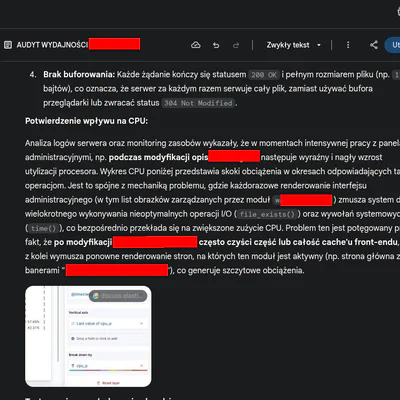

Mrugalski nie jest jedynym, który zauważył zwiększoną aktywność botów OpenAI. Analiza logów serwerowych na różnych stronach i sklepach internetowych potwierdza specyficzne zainteresowanie botów funkcją “embed” w WordPress oraz endpointami REST API. Co najważniejsze po sprawdzeniu stwierdziłem, że na moich serwerach skanuje głównie GPTBot, czyli używany do trenowania modeli, a nie OAI-SearchBot czyli do wyszukiwania. Skanowane są głównie Wordpressy. W sklepach magento bezmyślnie lata po parametrach produktów i searchu… próbując się wbić w login albo sekcję customer account. Chyba szuka wzorców. Omówię jednak tylko Wordpressa, bo tam znalazłem ciekawe anomalia.

Co OpenAI naprawdę robi z twoją stroną?

Istnieją trzy główne boty OpenAI, które możesz znaleźć w swoich logach:

GPTBot (user-agent: GPTBot/1.1 lub GPTBot/1.2) - używany do trenowania modeli generatywnych AI. Pełny ciąg user-agent:

Mozilla/5.0 AppleWebKit/537.36 (KHTML, like Gecko); compatible; GPTBot/1.1; +https://openai.com/gptbotOAI-SearchBot (user-agent: OAI-SearchBot/1.0) - używany do wyszukiwania i wyświetlania wyników w funkcjach wyszukiwania ChatGPT. Nie jest używany do trenowania modeli. Pełny ciąg zawiera

OAI-SearchBot/1.0; +https://openai.com/searchbotChatGPT-User (user-agent: ChatGPT-User/1.0) - używany, gdy użytkownicy ChatGPT lub Custom GPT zadają pytania i odwiedzają strony. Pełny ciąg:

Mozilla/5.0 AppleWebKit/537.36 (KHTML, like Gecko); compatible; ChatGPT-User/1.0; +https://openai.com/bot

GPTBot jest znacznie bardziej aktywny i szczególnie zainteresowany uproszczoną wersją stron WordPressa dostępną w formacie embed, np. pod adresami typu /nazwa-posta/embed/ w WordPress oraz innymi skanowanymi endpointami REST API. Dlaczego? Wszystko wskazuje na to, że OpenAI przygotowuje się do wprowadzenia bezpośredniego cytowania źródeł internetowych w odpowiedziach ChatGPT, podobnie jak funkcja już istniejąca w Microsoft Copilot. Jeśli chodzi o najpopularniejszego CMS Wordpress nie myl /embed/ z funkcją oEmbed, która służy do osadzania multimediów w treściach WordPressa – tu chodzi o techniczny format stron wykorzystywany przez boty.

Dlaczego embed jest tak interesujący dla GPTBota?

Wersje embed stron WordPress zawierają “czystą” treść bez elementów nawigacyjnych, co czyni je idealnymi do bezpośredniego cytowania. GPTBot prawdopodobnie będzie używać tych wersji do generowania fragmentów lub “snippetów” bezpośrednio wstawianych w odpowiedzi ChatGPT.

Jest to krok w kierunku zmniejszenia problemu halucynacji AI przez umożliwienie bezpośredniego cytowania źródeł zamiast ich interpretacji.

Efekt rich snippet – strategia zatrzymania użytkownika w ekosystemie

Co naprawdę dzieje się, gdy OpenAI wprowadzi bezpośrednie cytowanie źródeł? Odpowiedź możemy znaleźć analizując case Google vs. Wikipedia, który opisałem szerzej w moim artykule o palimpseście cyfrowym.

Google wprowadzając rich snippety z Wikipedii (fragmenty tekstu wyświetlane bezpośrednio w wynikach wyszukiwania) spowodował drastyczny spadek liczby wejść na stronę Wikipedii. Użytkownicy po prostu czytali wyświetlony fragment w Google i nie klikali dalej. Statystyki globalnie pokazały spadek ruchu na Wikipedii.

ChatGPT implementując podobną funkcję bezpośredniego cytowania dąży do:

- Zatrzymania użytkownika w swoim ekosystemie - użytkownik dostaje odpowiedź wraz z cytatem źródła, bez potrzeby opuszczania interfejsu ChatGPT

- Redukcji problemu halucynacji - cytowanie zamiast interpretowania to mniejsze ryzyko przekłamań

- Budowania zaufania do odpowiedzi - podanie źródła zwiększa wiarygodność

- Zmniejszenia ruchu na cytowanych stronach - tak samo jak w przypadku Wikipedii, można się spodziewać, że użytkownicy rzadziej będą klikać w podane źródła

Dla właścicieli stron oznacza to, że ich treści mogą być czytane przez użytkowników, ale bez generowania ruchu na stronie. Ich strony staną się de facto dostawcami treści dla AI, bez korzyści z wyświetleń reklam czy konwersji. Będzie trudno, ale nie beznadziejnie - bądźmy optymistami.

Co zrobić jako właściciel strony WordPress?

Opiszę ten konkretny case, ponieważ jest to jeden z najpopularniejszych CMSów. Macie obecnie taki dylemat:

Wyłączyć embed? Tradycyjnie, wyłączenie funkcji embed jest zalecane dla poprawy SEO (unikanie duplicate content) i zmniejszenia obciążenia serwera.

Zostawić embed? Jeśli chcesz, by Twoje treści mogły być bezpośrednio cytowane przez ChatGPT, pozostawienie funkcji embed ma sens.

A może kompromis?

Zachowaj embed, ale dodaj rel=canonical i obserwuj crawlera, bo GPT nie ma żadnego panelu do modyfikacji indeksu. W tym usuwania treści.

Co ważne dotyczy to oczywiście nie tylko Wordpressa, ale ten jest najbardziej popularny. Dodaj znacznik rel=canonical do wersji embed, wskazującego na oryginalną stronę, rozwiązuje problem duplikacji treści dla SEO, jednocześnie pozostawiając treść dostępną dla GPTBota:

| |

Optymalizacja strony wymaga też pracy nad zgodnością i różnymi standardami, w tym dopracowanie OpenGraph, ale jednocześnie zachowanie technologii embed, którą sporo osób wyłącza na WordPressie w celach optymalizacji. Zwróćcie też uwagę na to, że np. GPT realizuje search głównie po angielsku, Twoje pytanie tłumaczy na angielski, następnie generuje wyniki po angielsku i tłumaczy je z powrotem na polski. Języki inne niż angielski, w tym polski, nadal traktowane są jako drugorzędne w kontekście rozwoju AI. Na pewno się to zmieni, ale warto uwzględnić to ryzyko.

Dodatkowo możesz blokować

- Wyłącz XML-RPC - jeśli nie korzystasz z aplikacji mobilnych WordPress, wyłącz XML-RPC dla bezpieczeństwa (tutaj bot też się wbija).

- Blokowanie botów - jeśli nie chcesz, by Twoja strona była wykorzystywana przez AI, możesz zablokować odpowiednie deklaracje w robots.txt, ale najlepiej zakresy IP ze specyfikacji zablokować na firewallu albo na poziomie usługi (Apache/Nginx). Osobiście blokuję ipset/iptables tam gdzie chcę blokować.

MOJE NIEPOTWIERDZONE SPEKULACJE

UWAGA wkraczasz w rejon niepotwierdzonych spekulacji

Wzmożona aktywność botów OpenAI sugeruje, że zmierzamy w kierunku świata wojny przeglądarek oraz próby wysadzenia Google z biznesu, a to oznacza całkowitą przebudowę sposobu konsumpcji treści i wyszukiwania w internecie. Mało? AI będzie bezpośrednio cytować źródła internetowe zamiast je interpretować, a użytkownicy zapomną, że jest coś takiego jak wyszukiwarka bo będą po prostu rozmawiać albo otrzymywać porady przez alogrytmy predykcji. Moim zdaniem otwiera to nowe możliwości dla właścicieli stron jest to szansa na zwiększenie widoczności, ale też wyzwanie związane z kontrolą nad własnymi treściami. Przy wszelkich załozeniach i ryzykach o jakich pisałem w palimsescie cyfrowym o zanikaniu treści i manipulowaniu algorytmami rekomendacyjnymi w kontekście Google. Znajdziecie tam także fragmenty o predykcji i zmianach w algorytmie Google.

Niezależnie od decyzji moim zdaniem jeśli masz kompetencje techniczne, to warto monitorować logi serwerowe i być świadomym, jak i przez kogo Twoja treść jest wykorzystywana. Jeśli ktoś jest zainteresowany blokowanie IP, to lista zakresów znaduje się tutaj: Overview of OpenAI Crawlers w specyfikacji OpenAI.

Co nas czeka w perspektywie 2 lat

Obecnie obserwowany wzrost aktywności modeli AI i omawianych tutaj botów OpenAI to tylko wierzchołek góry lodowej zmian, które nadchodzą w najbliższych latach. Chciałbym się z wami podzielić jako specjalista w branży z moimi lękami, przemyśleniami… co nas czeka za kilka lat:

1. Wyszukiwanie zdominowane przez AI

Tradycyjne wyszukiwarki prawdopodobnie odejdą od modelu “10 niebieskich linków” na rzecz bezpośrednich odpowiedzi generowanych przez AI. Google, Bing i inne platformy będą dostarczać gotowe syntezy treści zamiast odsyłać do źródeł - wbudowane fragmenty stron będą jedynym śladem źródła. SERP (wynik wyszukiwania) odejdzie w niepamięć jak Netscape.

2. Koniec tradycyjnego SEO

Jeśli AI stanie się pośrednikiem między treścią a użytkownikiem, klasyczna optymalizacja pod wyszukiwarki straci sens. Firmy będą musiały walczyć o uwagę algorytmów AI, a nie bezpośrednio użytkowników. Oczywiście od dwóch lat zbieram praktyczną wiedzę jaki jest potencjał w manipulowaniu algorytmami AI. Jest to możliwe i nie tylko w zakresie krótkoterminowym jak zatruwanie danych… Zatruwanie danych to celowe wprowadzanie błędnych lub mylących informacji do zbiorów treningowych AI, co może wpływać na jej odpowiedzi. Przykładem jest próba manipulacji treściami w Wikipedii albo masowe generowanie serwisów z wiadomościami, by zmylić modele językowe. SEO ewoluuje w stronę optymalizacji pod AI, co może być wyzwaniem, ale też szansą dla twórców oferujących unikalne treści. Jedynym zagrożeniem jakie widzę dla takiej twórczości to SEO heist, czyli kradzież treści przy użyciu AI - może zagrozić twórcom, jeśli ich unikalne materiały zostaną wykorzystane na masową skalę do tworzenia generatywnych klonów stron. Dlatego uważam, że pozostaną niszą, bo wychodząc ponad średnią zwrócą uwagę spamerów.

3. Treści generowane przez AI

Znacząca część nowych treści online będzie tworzona przy udziale AI lub całkowicie przez AI, co może prowadzić do zalania sieci materiałami o niskiej wartości merytorycznej. Każdy się tego boi, moim zdaniem postawi to granicę pomiędzy tym co było kiedyś, a erą całkowicie generatywną. Paradoksalnie widzę szansę dla ludzi posiadających nie tylko prawdziwe kompetencje co również pasję…

4. Pogłębienie baniek informacyjnych

Tutaj niestety nie mam dobrych wiadomości. Przegrywamy z dezinformacją. Algorytmy rekomendacji będą tak wyrafinowane, że użytkownicy będą funkcjonować w całkowicie spersonalizowanych środowiskach informacyjnych, co ograniczy różnorodność i przypadkowe odkrycia. Krytyczne myślenie może być trudniejsze do utrzymania w środowisku zdominowanym przez algorytmy.

Perspektywa 5 lat: transformacja internetu

1. Internet multimodalny

Działając od 2008 rok w branży widzę jak urządzenia nie tylko zwiększały nasycenie użytkownikami i obniżały poziom treści, ale także przyspieszały konsumpcję treści i zmieniały formaty prezentacji. Interfejsy tekstowe mogą zostać w dużej mierze zastąpione przez interakcje głosowe, wizualne i mieszane (AR/VR), zmniejszając zapotrzebowanie na tradycyjne strony internetowe. Widać to szczególnie w formacie YT, podcast, ale także planowanym metaversum.

2. Konsolidacja platform - ogrodzony ekosystem “walled garden”

Nie mam tutaj dobrej wiadomości. Niewielka liczba megaplatform prawdopodobnie przejmie kontrolę nad dostępem do większości treści, działając jako “bramy” do internetu. Widać wyraźnie w panicznej próbie ucieczki i uwolnienia się niektórych redakcji spod prymatu algorytmu, że wyjście jest to już praktycznie niemożliwe. Coś jak teraz model UberEats i całkowita dominacja w SERP oraz zamówieniach jedzenia na dowóz. Jest to efekt walled garden, czyli zamkniętego ekosystemu i tworzenia gospodarek platformowych. Zjawisko to wykorzystuje network effect (efekt sieci). Im więcej podobnych firm korzysta z tego rozwiązania, tym większa jego wartość. Firmy, które nie widzą możliwości wejścia w biznes na własną rękę, zaczynają się uzależniać od platformy. Próg wejścia samemu albo wyjścia jest tak duży, że nie mamy innej opcji jak być na platformie. Przypomina mi to trochę case redakcji Wyborczej migracji z X na BSKY.

3. Zanik “otwartego” internetu

Swobodne przeglądanie i odkrywanie treści może zostać zastąpione modelem, w którym AI kuratorzy decydują o tym, co użytkownik zobaczy. Shadow profile budowany na podstawie naszych interakcji będzie praktycznie prowadził nas za rękę.

4. Kryzys monetyzacji treści

Tradycyjne modele biznesowe oparte na reklamach i ruchu organicznym mogą stać się nieopłacalne, prowadząc do zaniku niezależnych twórców treści. Próg wejścia w internet dla firm będzie tak duży, że siłą rzeczy trzeba będzie nawiązać współpracę z pośrednikami.

5. Internety regionalne

Internet może stać się bardziej sfragmentaryzowany geograficznie, z odrębnymi ekosystemami w różnych regionach świata, podlegającymi lokalnym regulacjom. Będzie to spowodowane obostrzeniami, różnymi wymogami moderacji, co już widać na Facebooku, który deprecjonuje widoczność treści w zależności od lokalnej kultury.

Dead Internet Theory w kontekście AI

Teoria “martwego internetu” (Dead Internet Theory) zakłada, że znaczna część internetu jest już generowana przez boty i programy AI, a nie ludzi. Choć w swojej skrajnej postaci ta teoria brzmi jak spiskowa, obecny rozwój generatywnych modeli AI sugeruje, że jej umiarkowana wersja może stać się rzeczywistością. Tym samym sfalsyfikujemy teorię spiskową i stanie się faktem.

Zmanipulowanie AI na dużą skalę będzie polegało na tzw. poisoningu (zatruwaniu danych) połączonym z wysokiej jakości SEO. W rezultacie możemy spodziewać się zalewu generatywnych treści o niskiej wartości merytorycznej, ale zoptymalizowanych pod algorytmy AI i wyszukiwarki.

W takim środowisku paradoksalnie powstaje ogromna nisza dla twórców oferujących autentyczne, niegeneratywne treści. Jednak utrzymanie się w tej niszy będzie wymagać:

- Ignorowania statystyk w początkowej fazie, gdy generatywne treści będą dominować

- Większego nacisku na interakcje ze społecznością

- Aktywizowania czytelników

- Tworzenia materiałów o niepodważalnej jakości

Nie każdą firmę lub indywidualnego twórcę będzie na to stać. Szczególnie przegrają ci, którzy jak mój znajomy architekt, przeszli całościowo na platformy społecznościowe (np. Instagram), rezygnując z własnej domeny i strony internetowej.

Czy jest jakaś nadzieja?

Bunt użytkowników zadziałał w przeszłości – np. masowe odejścia z Facebooka po skandalu Cambridge Analytica. Pomimo ponurej wizji moim zdaniem istnieją czynniki, nie da się ukryć, które mogą zmienić bieg wydarzeń:

Decentralizacja i Web3 - Technologie jak blockchain, IPFS czy platformy typu Mastodon mogą oferować alternatywę dla korporacyjnej dominacji. Wbrew ekstazie społeczności składającej się głównie z informatyków i aktywistów przy każdej rzekomej migracji z Twittera na alternatywy czyli przede wszystkim Mastodona, nie widzę jeszcze sygnałów, aby Mastodon albo niszowe rozwiązania jak NOSTR miały zagrozić dominacji Big Techów.

Regulacje rządowe - Inicjatywy jak unijny AI Act czy Digital Services Act próbują ograniczyć władzę big techu. Tutaj chyba największa nadzieja o ile nie pójdziemy w kierunku “muskowej” deregulacji. Tutaj odsyłam po prostu do projektów UE, bo chyba tylko UE stanowi przeciwwagę dla tech bros.

Technologiczne przełomy - Zawsze można liczyć na cud, prawda? Jakieś nieprzewidziane innowacje, które mogą wywrócić obecny porządek. Niewykluczone, że nowe innowacyjne urządzenia albo rozwiązania rozchwieją scementowany system i pojawią się nowi gracze. O ile nie zostaną wcześniej wykupieni za setki milionów dolarów.

Bunt użytkowników - Najmniej realny scenariusz. Jakkolwiek historia pokazuje, że ludzie czasem odwracają się od toksycznych platform, co może zmusić firmy do zmiany podejścia, to nie byłbym aż tak naiwny, że Zuckerberg nie będzie chciał zrobić z nas darmowych pracowników. Instagram już dzisiaj generuje więcej treści tworzonych za darmo i generuje większe dochody niż ma Netflix, który wydaje miliardy na swoje produkcje.

Praktyczne wnioski

Nie rezygnujcie ze stron internetowych np. przenosząc się na Facebooka/Instagrama. Dla właścicieli stron i twórców treści w obliczu tych zmian ważne jest abyście długoterminowo budowali relacje z odbiorcami. Budujcie odbiorców modelowych i starajcie się dotrzeć do nich poprzez niezależne platformy (newsletter, społeczności). Nie twórzcie treści przy użyciu AI. To właśnie oryginalna i czasami słabo zredagowana treść będzie wartością w świecie idealnych treści, idealnych fotek i idealnego odrealnionego od zła życia. Rozumiem niechęć do różnych formatów, ale musicie testować różne rozwiązania i ekosystemy. Tak jak pisałem w palimpseście cyfrowym: jeśli chcecie przetrwać w internecie i utrzymać się na powierzchni musicie się adoptować.

Internet, jaki znamy i pamiętamy, czyli otwarty, chaotyczny, pełen możliwości raczej zmierza ku zanikowi. Staje się powoli przeszłością. Jednak ostateczny kształt tej zmiany zależy również od aktywności i świadomości użytkowników sieci. Wielokrotnie krytykowałem fediwersum, ale robiłem to nie dlatego, że jestem przeciwny idei, ale chciałbym aby stanowiła realną alternatywę dla Big Tech.